Transcription

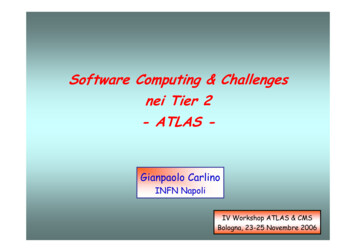

Software Computing & Challengesnei Tier 2- ATLAS -Gianpaolo CarlinoINFN NapoliIV Workshop ATLAS & CMSBologna, 23-25 Novembre 2006

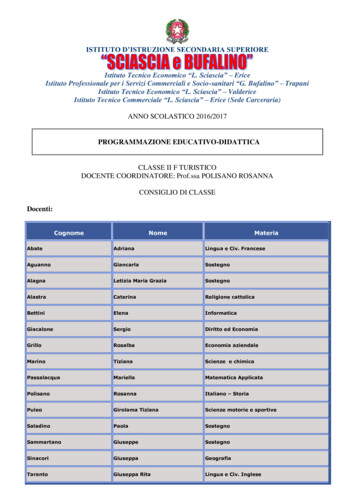

L’ATLAS Computing Model Pb/sec10 GB/secEvent BuilderEvent Filter 159kSI2k Some data for calibrationand monitoring to institutes450 Mb/sec Calibrations flow backTier 0 9 Pb/year/T1No simulationT0 5MSI2k 300MB/s/T1/exptTier 1Italian RegionalCentreUS RegionalCentreSpanish RegionalCentre (PIC)UK RegionalCentre (RAL) 622Mb/sTier 2LancasterLiverpool Manchest Sheffield 0.25TIPSerPhysics datacacheWorkstationsIV Workshop ATLAS & CMS: Bologna 2006100 - 1000MB/sCentreTier2 CentreCentre¾ LTier2’Eventdata Tier2flowdall’ on-line 200kSI2k 200kSI2k 200kSI2k¾ Il Formato dei dati¾ La struttura a Tiers 200 Tb/year/TEach Tier 2 has 25 physicists working¾ La catena di Produzione degli eventi:on one or more channels¾ Simulazione, ProduzioneEach Tier 2 shouldhave the fullAOD, ManagementDistribuitae DataTAG & y data¾ I Data ChallengesTier 2 dosimulation dei Tier-2 Italiani¾ bulkLa ofFederazione¾ Sviluppo delle Risorse del Computing¾ ConclusioniNorthern Tier 200kSI2k 622Mb/s 7.7MSI2k/T1 2 Pb/year/TG. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-22

Data FlowOnline (sistema di Trigger e DAQ) Offline (Tier-0) Pb/secEvent Builder10 GB/secEvent Filter 159kSI2k Some data for calibrationand monitoring to institutes320 MB/sec Calibrations flow backTier 0T0 5MSI2k Trigger rate: 200 Hz (indipendente dalla luminosità) Dati trasferiti all’input buffer del Tier-0 a 320 MB/s (average) Eventi scritti in formato byte-stream (output dei rivelatori) in file da max 2 GB(1 file/stream/SFO/lumi block) 1000 eventi/file (size nominale 1.6 MB/evento). 16k file al giorno. Il Tier-0 input buffer dovrà conservare i raw data in attesa della ricostruzione:9 125 TB, sufficienti a 5 giorni di presa dati9 90% dei dati ricostruiti in max. 48 ore.IV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-23

Streaming dei datiSono previste 4 classi di stream di dati generate all’ output dell’ Event Filter: express stream, con gli eventi “più interessanti” che devono esserericostruiti rapidamente. Time scale: ore! Motivazioni principali:calibrazione, controllo della qualità dei dati e avviso rapido di presenza dieventi particolarmente interessanti. Menù di trigger in via di definizione.Tutti gli eventi sono anche nelle altre stream.calibration streams, con i dati necessari per le calibrazioni dei detector(Muon dal LVL2, LAr, ID .). Non contengono l’evento completo.debugging stream, contenente eventi che presentano problemiphysics stream, un’unica stream è stata sostituita dalle seguenti sottostream basate sulle segnature di trigger: Muon triggers Electromagnetic triggers (elettroni e fotoni) Hadronic triggers (jets, tau e missing energy) B-physics triggers Minimum bias e altri prescaled triggers per monitoringStream inclusive o esclusive con l’aggiunta di una stream di overlapIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-24

Event Data Model: tipi di datiNelle varie fasi di ricostruzione e analisi ATLAS utilizza diversi tipi di dati:1.6 MB/eventtarget500 KB/eventattualmente1,2 MB/eventtarget100 kB/eventattualmente130 kB/eventtarget1 kB/eventattualmente1,3 kB/eventRAWRaw Data:Data dati in output dal sistema di trigger eacquisizione in formato byte-streamEvent Summary Data:Data output della ricostruzioneESD(tracce e hit, celle e cluster nei calorimetri,combined reconstruction objects etc.).Calibrazione, allineamento, refitting Rappresentazione object-oriented POOL/ROOTAnalysis Object Data: rappresentazione ridottaAODdegli eventi per l’analisi: oggetti “fisici” ricostruiti(elettroni, muoni, jet, missing Et .).Back Navigation agli ESDRappresentazione object-oriented POOL/ROOTTag: informazioni sintetiche per selezione veloceTAGIV Workshop ATLAS & CMS: Bologna 2006degli eventi negli AOD e/o ESD. Formato DB relazionale per ricerche veloci Formato ROOT per istogrammazione veloceG. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-25

Il Modello a TierIl modello generale di calcolo per l’offline e l’analisi di ATLAS è quellogerarchico multi-Tier.Modello a cloud: ad ogni Tier-1 sono associati alcuni (3 o 4) Tier-2spesso i base a considerazioni geografiche.Tier-0 (CERN) PB/sEvent Builder10 GB/sEvent Filter320 MB/s Archivio dei RAW data ricevuti dall’EF e distribuzione ai Tier1 Prompt Reconstruction delle calibration e express stream Prompt Reconstruction dell’event stream Distribuzione output ricostruzione (ESD,AOD,TAG) ai Tier-1Tier0Tier-1 (10) Accesso a lungo termine e archivio di un subset di RAW data 10 Copia dei RAW data di un altro Tier-1 Reprocessing della ricostruzione dei propri RAW data con parametri di 50 Mb/scalibrazioni e allineamenti finali e distribuzione AOD ai Tier-2 Archivio dati simulati MC prodotti nei Tier-2 3 3- 150 MB/sTier1Tier24/Tier1Tier3 Simulazione Monte Carlo AnalisiIV Workshop ATLAS & CMS: Bologna 2006Tier-2G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-26

Event Data Model: replica e distribuzione datiPer rendere efficiente l’accesso ai dati per ricostruzioni (nei Tier-1) e analisi (neiTier-1/2) è previsto un certo livello di ridondanza, con repliche dei dati in più Tier.RAWESD Dati originali al Tier0 Replica completa nell’insieme dei Tier-1 Gli ESD prodotti con la ricostruzione primaria risiedono al Tier-0 evengono esportati in due copie ai Tier-1 Versioni successive degli ESD prodotte nei Tier-1 (ognuno riprocessa isuoi RAW) e replicate in due copie ad un altro Tier-19 insieme completo di ESD su disco in tutti i Tier-1 europeiAOD Gli AOD prodotti con la ricostruzione primaria risiedono al Tier-0 esono replicati in ogni Tier-1 (10 copie) Replicati parzialmente nei Tier-2 ( 1/3 – 1/4 in ciascun Tier-2) inmodo da avere almeno un insieme completo fra i Tier-2 della cloud9 ogni Tier-2 specifica i dataset più interessanti per la comunità diriferimentoTAG I database dei TAG sono replicati in tutti i Tier-1 (Oracle DB) Repliche parziali dei database TAG nei Tier-2 (Root files)9in ciascun Tier-2 risiedono almeno tutti i file Root dei TAG corrispondentiagli AOD ospitati nel sito.IV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-27

Ruolo dei Tier-2Il Modello a cloud prevede 3 o 4 Tier-2 per ogni Tier-1Ruolo dei Tier-2 previsto nell’ ATLAS computing model: Simulazione Monte Carlo Analisi dei gruppi di Fisica e degli end-user Sviluppo di codice Calibrazione e allineamento per subdetectors di interesse locale¾ Gli istituti responsabili della calibrazione di particolari subdetectors prevedono diprocessare i dati di calibrazione in un Tier-2 dedicatoFormato dei dati da ospitare: Copia completa nei Tier-2 della cloud di AOD di dati reali ( 200 TB/anno) eMonte Carlo ( 60 TB/anno, 30%) Copia completa dei TAG ( 2 TB/anno) MC RAW data e ESD. Buffer per la produzione di un mese ( 1 TB) Campioni di ESD e RAW data per sviluppi, ESD e (possibilemente) RAW data per le calibrazioni O (TB) Conditions data per le calibrazioni¾ Grandi quantità ma per particolari sottorivelatori e periodi di presa datiFino ad ora i Tier-2 hanno assolto pienamente e con buona efficienza al ruolo dicentri di produzione Monte CarloIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-28

La catena dellaProduzione Monte Carlo:Simulazione,Produzione Distribuitae Data Managementin GridIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-29

La Simulazione Monte CarlozzLa simulazione di ATLAS, come tutte le altre applicazioni, gira in un frameworkcomune per l’event processing (ATHENA) Basato su Gaudi Separazione tra dati e algoritmi Separazione tra dati transienti (in memoria) e persistenti (in file) Steering attraverso Job Options scritti in PythonLa descrizione della Geometria del Detector, GeoModel, è disaccoppiata dalframework di simulazione Fornisce una rappresentazione transiente della Geometria basata su numeriprimari che descrivono il detector e costanti d’allineamento conservati in un DBbasato su un sistema di “Hierarchial Versioning” La Geometria usata nella simulazioneviene derivata direttamente dal GeoModel Memoria 90 MB In questo modo la Simulazione e laRicostruzione utilizzano automaticamentela stessa rappresentazione geometricadel rivelatoreIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-210

La Simulazione Monte CarlozzzGenerazione eventi fisici: interfaccia ai principali packages di generatoriSimulazione con Geant4 dagli inizi del 2004 ( 120M eventi 2004-05) Geometria automaticamente derivata dal GeoModel Geometrie “nominali” o “reali” Simulazione della risposta del rivelatore (HITS e RDO) Mixing con il pile-up a livello di digitizzazioneValidazione intensiva per evidenziare performance non ottimali, inconsistenzeinterne o descrizioni inaccurate del rivelatore Performance in termini di CPU time e uso di memoria¾zCrescita dei tempi di simulazione (average 400 kSI2kkSI2k-sec) PiùPiù accurata Detector Desription η 6 invece di 3 Confronto con dati reali:Test Beam Combinato Physics PerformancesUso della Fast simulationper studi di fattibilità e di(physics) backgroundad alta statisticaIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-211

Sistema di Produzione Distribuita ATLAS utilizza in maniera estensiva i tool di Grid per le sue produzioni di datisimulati. Attività svolta in parallelo con l’analisi distribuita comportandol’accesso di molti utenti alle risorse e ai dati nei vari siti Necessità di organizzare l’accesso e l’utilizzo delle risorse con un sistema interno dipriorità per poter assicurare che lo share di risorse allocato alle varie ettività e adisposizione dei vari utenti sia coerente con le priorità decise dall’esperimentoATLAS Virtual Organization: caratterizzazioni degli utenti in base a ruoli e gruppiATLAS ha già svolto numerosi esercizi di prodozione distribuita in larga scala:scala DC1 in 2002-2003, DC2 in 2004, “Rome Production” in 20059 Numerosi decine di milioni di eventi completamente simulati e ricostruitiCSC (Computing System Commissioning) nel 2006 e 2007 DC2 e “Rome production” sono stati interamente eseguiti sulla Grid Uso di 3 Grids MondialiLCG ( EGEE): Europa OSG/Grid3 (US): AmericaNorduGrid: Nord EuropaI file di input e output devono essere accessibili da tutte le GriglieIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-212

ATAu LAtu S Dmn C20 204Il Sistema a 3 GriglieNumber of sites;resourcesare evolving quicklyIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-213

Sistema di Produzione Distribuita Per produrre i dati necessari ai vari DCè stato sviluppato un sistema diproduzione automatizzato, ProdSys l’architettura consiste di 4 componenti: Il Production Database (DB ORACLEal CERN) in cui sono definiti i job diATLAS raggruppati in:99 IV Workshop ATLAS & CMS: Bologna 2006Datasets (definiscono il contenuto fisico diuna collezione di job)Tasks (identificano tutti i job dello stessodataset)Un Supervisor (Eowyn) che selezionaun job dal ProdDB e lo manda aidifferenti Grid executors e neverifica lo stato. Risottomette i job incaso di failureGli Executors (moduli Python), uno perogni Grid flavour, ricevono i jobdefinitions in formato XML, liconvertono nel linguaggio dellaparticolare Grid e li sottomettonoindividuando le risorse ottimali (CPUvs Dati) sulle infrastrutture di calcoloDonQuijote (DQ2), il DataManagement System, si occupa dellagestione e distribuzione dei dataset.G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-214

Distributed Data Management ModelIl sistema di Distributed Management (DDM) di ATLAS, Don Quijote (DQ2), permettel’implementazione delle funzionalita’ previste dal Computing Model: Distribuzione di dati raw e ricostruiti, reali e simulati, tra i vari Tier Catalogazione dei dataset (aggregazione di file e relativi metadata)Il sistema, ridisegnato nel 2005 e in alcune sue parti ancora in fase prototipale, hainfatti un’organizzazione basata sui datasets:datasets Cataloghi di dataset centrali, suddivisi in vari DB per facilitare l’accesso Dataset Repository, Dataset Content Catalog, Dataset Location Catalog, DatasetSubscription Catalog Cataloghi di file distribuiti (locali) Non ci sono cataloghi globali di file: il mapping nome logico nome fisico è fatto localmentesui cataloghi localizzati nei Tier-1 che contengono soli i file salvati nella cloud. LFC (LCG FileCatalog) è il Local Replica Catalog Sistema di sottoscrizione Sistema per il trasferimento automatico dei dati.Ogni sito si sottoscrive a un dataset ele nuove versioni deldataset vengonoSubscriptionsautomaticamente rese phys.esd.001:CERN, CNAF,disponibili ad ogniBNLphys.aod.001: CERN, CNAFvariazioneIV Workshop ATLAS & CMS: Bologna ys.aod.001G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei 00115

Analisi Distribuita Il Modello di Analisi Distribuita di Atlas è in fase di evoluzione: Task Force per determinare il “Miglior Modello” tenendo conto delle necessità degliutenti (velocità e semplicità di accesso ai dati) e dei gruppi di fisica (separazionetra in- e out-of-framework analysis), back-navigation all’intero evento Test su scala significativa nel CSC Uso delle risorse per l’analisi I Tier-2 ospitano job di analisi sia individuale che di gruppo9 Il Computing Model prevede che il 50% delle risorse di CPU siano dedicate all’analsi I Tier-1 possono accogliere job di analisi di gruppo Analisi locale per ottimizzare l’efficienza del processamento dei dati1. Selezione degli eventi da TAG e analisi sugli AOD degli eventi selezionati2. Determinazione dei siti dove i dati sono memorizzati3. Invio in questi siti (tramite Grid tools) dei jobs ed estrazione delleinformazioni più rilevanti:9 nella forma di DPD (ntuple) da usare localmente in modo interattivoIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-216

Analisi Distribuita: selezione dei datiSelezione TAG based Apertura di una sessione tramite un’interfaccia (GANGA)che permette di eseguire tutte le operazioni d’analisi: Job configuration, submission, splitting, merging, monitoring,output retrieval“TAG, 2μ, 2009, ” Interrogazione del Dataset Content Catalog che contienei metadata per ogni dataset del tipo desiderato pertrovare quelli che gli interessanoDataset C Esempio di query: dammi la lista dei dataset con trigger 2μdel 2009, versione x.y.z del software etc . Localizzazione tramite il Dataset Location Catalog delsito (cloud) dove risiede il dataset Passaggio dai dataset ai singoli files tramite il Local FileCatalog presente in ogni Tier1 della cloud Applicazione dell’ algoritmo di selezione sui dataset sceltie produzione di una lista di eventi accettati In Athena è disponibile il tool che per ogni dataset permettedi processare solo gli eventi specificati via TAG listIV Workshop ATLAS & CMS: Bologna ectioncriteriaEvent 1,Event 3,Event 6LFCDataset C: File 1 File2G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-2CNAF17

Analisi Distribuita: data processing Selezionati gli eventi, sottomissione alla Grid deijob di analisi tramite il Work Load Manager(WLM), nei siti dove risiedono gli eventiUn job può dare come output una nuova collezionedi eventi, che può essere registrata come nuovodataset nei cataloghi e acceduto successivamente In DQ2 è possibile sottoscrivere uno o più siti comedestinazione del dataset e quando il dataset ècompleto viene inizializzato il trasferimento con FTS La possibilità di generare nuovi dataset consistentisarà ristretta (almeno inizialmente) ai responsabilidelle produzioni dei gruppi di fisica Estrazione dall’insieme dei dati analizzati (informato AOD) dei file di Derived Physics Data(tipo n-tupla o altro formato privato) che potràpoi essere analizzare interattivamente in locale.IV Workshop ATLAS & CMS: Bologna 2006Work LoadManagerJob 3LFCDatasetC C: File 5 NAF File 6 ComputingElementDPD/Ntuple File 5 File 6LFCJob 2Job 1Dataset A: File 1 File 2CERN DatasetLocationCatalogEvent 1, SubmissionEvent 3,toolEvent 6 Il Dataset Location Catalog localizza i siti doverisiedono i dataset contenenti gli eventi accettati econ il Local File Catalog, si passa ai singoli filesresidenti sugli SEComputingDataset B:Element File 3 File 4DPD/Ntuple File 3 File 4 DPD/Ntuple File 1 File 2G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-218

Analisi Distribuita: il modello attualeAthenaESDCellsegammaAOD BuildingJetCMuonMETTauObjElectronMuon Copy select infoPhotonMET Slim: make“lighter” objects.PJetTruthP Thin (eg removesome usterTrackPTruthROOT2. Out-of-FrameworkAnalysisIV Workshop ATLAS & CMS: Bologna 2006 “Recalibrate” Select Obj/Remove overlap Complicated Tasks Calculate DPDAthena/EVHistogramsAthena/EV2 Stage UserAnalysis1. Framework AnalysisDPD (Ntuple)El p T[]Ph p T[]Mu p T[] Further AnalysisEl eta[]Ph eta[]Mu eta[] Make plotsMissingEtTop mass[]M effEvent Data User DataG. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-219

I Data Challenges diATLASIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-220

Validazione del Computing ModelLHC Computing Review (2001)“Experiments should carry out Data Challenges of increasing size and complexityto validatetheir Computing Modeltheir Complete Software suitetheir Data Modelto ensurethe correctness of the technical choices to be made”Validazione del Modello attraverso una serie di challenges di crescente complessità: Data Challenges (DC1 e DC2, 2001-2004) Computing System Commissioning (CSC, 2006-2007) Calibration Data Challenge (primo semestre 2007) “Final Dress Rehearsal” (secondo semestre 2007)In parallelo sono state sviluppate la produzione “continua” per fornire i dati all’analisi fisica9 “Rome” production nel 2005 (physics workshop)9 CSC nel 2006 Test più specializzati:9 Tier-0 scaling tests9 Service Challenges & Data Transfer Functional testIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-221

Storia dei Data ChallangesDC1 (2002-2003) Primo “esercizio” di ATLAS su scala mondialeSviluppo e test della full software chain9Simulazione dei dati; digitizzazione; pile-up; ricostruzione999NorduGrid: tutta la produzione eseguita in GridUS: Grid usata alla fine del testLCG-EDG: solo test durate il Data Challenge ma non una “reale” produzioneDati Monte Carlo necessari per l’ ”High Level Trigger Technical Design Report”Production system preliminareUso “preliminare” della GridDC2 (2004) Stessi esercizi del DC1Introduzione del nuovo ProductionSystem (ProdSys)9 Produzione in siti sparsi nelle tredifferenti Griglie20 Nazioni, 69 siti, 260k jobs Rome Production (2005) Produzione di dati simulati per ilPhysics Workshop a Roma nelGiugno 2005 usando leinfrastrutture del DC222 Nazioni, 84 siti, 570000 jobsIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-222

Il Computing System CommissioningzIl principale scopo del Computing System Commissioning (CSC) è di testare evalidare le infrastrutture del software e del computing che saranno utilizzate dal2007 per l’analisi fisicaz Procedure di Calibrazione e Allineamento Full trigger chain Messa a punto della catena completa di Produzione, Simulazione,Ricostruzione degli eventi e Distribuzione dei Dati Accesso distribuito ai dati per l’analisiIl CSC durante il 2006 è stata più che altro un’ operazione di produzionecontinua che un challenge stand-alone 50 M eventi di fisica e particelle singole prodotti in 6 mesi con la release11 del software di ATLAS; Informazioni del trigger negli ESD/AOD (trigger aware analysis)IV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-223

Produzioni nel 2006Atlas Wall Clock Time per Region (Jan-Oct KIRussia2%France9%NorthernEurope4%IV Workshop ATLAS & CMS: Bologna 2006Italy10%GermanySwitzerland5%G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-224

Produzioni nel 2006Wall Clock Time at Tier-1s (Jan-Oct 23%IV Workshop ATLAS & CMS: Bologna 2006TRIUMF-LCG2USCMS-FNAL-WC10%G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-225

Il Computing System CommissioningAttività del CSC nel periodo fine 2006, inizi 2007 Basata sulla produzione di eventi corrispondenti ai primi 100 pb-1 di dati:920 M eventi con la release 12 del software di ATLAS in corso (10 Meventi/mese). Ricostruzione da Dicembre. 40 M eventi nel primo trimestre2007 La release 12 permette di scegliere tra configurazioni geometriche dirivelatore ideale e “as installed”:¾Geometria ideale¾Geometria disallineata¾Geometria disallineata e “distorta” Mappa più realistica del campo magnetico (parziale asimmetria) Descrizione accurata del materiale inerte e dei canali morti Full trigger simulation e studio dei trigger menusIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-226

Le Note CSCLavoro finalizzato nella prima metà del 2007 in una serie di note (CSC notes) Lo scopo non è quello di scrivere delle note (aggiornando i risultati delTDR di fisica) ma di rendere l’intero sistema funzionante e operativo per ildata taking Sinergia tra attività di software/computing, studio di performances &analisi per evitare duplicazioni e creare integrazioni tra i gruppi Sono stati definiti circa 100 argomenti fra performances e studi di fisica 13 note con editore italiano¾3 Higgs, 1 Top, 2 SuSy, 1 B-physics, 1 b-tagging, 4 jets, 1 muoniLa simulazione dei dati con set-up realistici associa le attività del CSC a quelle delCalibration Data Challenge¾note di processi molto sensibili alle calibrazioni del rivelatore (Higgs γγ,muoni, b-tagging)IV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-227

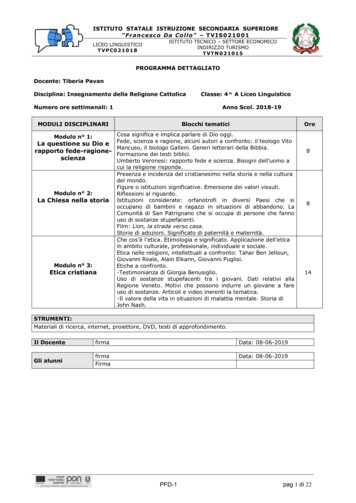

Calibration Data ChallangeGeometry of“as-installedmis-aligned”detectorIn Release 12.0.3(current)G4-simulation ofcalibration samples[O(10M) events,e.g. Z ll]Calib/alignconstantsfrom pass N-1Reconstruction pass N(Release 13, Feb. 07)Pass 1 assumes perfectcalibration/alignmentand nominal materialAnalysisCalib/alignconstantspass NCondition DataBaseverifica della funzionalità del calibration ‘closed loop’:1.2.3.simulazione del un rivelatore imperfetto (realistico) e ricostruzione assumendo ilrivelatore idealedeterminazione del set finale di correzioni, allinemaneti e costanti di calibrazioneconfronto delle performance con quelle nominali (TDR)e del processing degli algoritmi di calibrazione9999nel framework offline del softwarecombinando le informazioni di vari sottorivelatoriconditions database in ambiente distribuitorealistico streaming dei datiIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-228

Simulazione Realistica del rivelatoreRealistico Come installato al pit¾Shift di tutti le principali parti delrivelatore già installate in accordo allemisure di survey ( mm)Toroid ‘egg-shape’¾calo-cells, R-t relations¾Moduli ID e camere a muoni¾ Δx 0.mmΔy 7.mmΔθ 0.Δx -1.75 mmΔy 5.25mmΔθBOL 1 mradΔθBML 1.3 mradΔθBIL 1.8 mradMis-calibratoMis-allineatoDeformazioni e wire saggingB-field map migliorata, includendotilt/shift rispetto alla posizionenominale dell’asseDescrizione accurata del materialeΔx -3.5mmΔy 3.5mmΔθ 0.Δx 3.5mmΔy 3.5mmΔθ 0.Toroid‘egg’Δx 0.Δy 0.ID γ conversionmapEsempio di ricostruzione del pt nell’ID simulatione mis-allineata, ricostruzione nominaleIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-229

Il Final “Dress Rehearsal”Esercizio completo dell’intera catena, dall’ on-line & trigger all’analisidistribuita, da eseguire nel secondo semetre del 2007, poco primadell’inizio del data taking: Generazione di eventi MC simulando lo spettro fisico atteso e pochi giorni di datataking ( 1 pb-1 a L 1031 cm-2 s-1 ) G4 simulation (geometria del rivelatore realistica “as installed” ) Mix degli eventi dei vari canali di fisica per riprodurre l’output dell’HLT Simulazione del trigger, produzione del byte stream (emulando i RAW data) estreaming degli eventi Trasmissione degli eventi dal Point 1 al Tier0 Processamento delle calibrazioni e dell’allineamento al Tier0 Ricostruzione al Tier0 produzione di ESD, AOD, TAG Distribuzione di ESD, AOD, TAG ai Tier-1 e Tier-2 Processamento dell’analisi distribuita (possiblmente ai Tier-2) usando i TAGIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-230

I Tier-2 italiani diATLASIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-231

I Tier-2 italianiLa richiesta di infrastrutture di calcolo di ATLAS Italia è motivata dalla necessità di integrarsi nel modello di calcolo di ATLAS costituire un supporto adeguato alle attività di calcolo italiane Ricostruzione: Muon Detector, Calorimetri, Pixel Detector Calibrazioni/allineamento: MDT, RPC, Calorimetri, Pixel Detector, DB Studi di performance: Muoni, Tau/jet/EtMiss/egamma Analisi: Higgs, Susy, Top, Fisica del B Simulazione (soprattutto legate alle attività elencate)Per assolvere alle funzioni richieste dalle attività della comunità italiana il sistema hauna struttura gerarchica articolata in Tier-1 e Tier-2 i quali svolgono compitisostanzialmente complementari Per garantire la massima flessibilità ed efficienza è stato proposto un numerosignificativo di centri Tier-2 in accordo al numero di utenti e allaclusterizzazione della attività italiane.IV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-232

I Tier-2 italianiNell’ultimo anno vi è stata un’accurata attività di referaggio da parte dell’INFN suisiti candidati ad assolvere alla funzioni di Tier-2. Criteri di valutazione: infrastrutture (già disponibili o richieste) e sinergie con altri progetti gruppi: dimensioni del gruppo, manpaower (tecnici/tecnologi e fisici), esperienzapregressa in GRID e dimensioni della comunità di riferimentoL’attività di refereggio ha portato alle seguenti conclusioni:¾ Tier-2 approvati Napoli e Roma1¾ Tier-2 sub-judice: Milano¾ Proto Tier-2 FrascatiIV Workshop ATLAS & CMS: Bologna 2006L’upgrading dei siti non ancora approvati è legata alsuperamento delle eventuali carenze di tipoinfrastrutturale o di manpower e soprattutto alla capacitàda parte dei Tier-2 di costituire una organizzazione, alivello di federazione, in grado di sfruttare le risorsedisponibili nel Tier-1 e nei Tier-2 esistenti.G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-233

I Tier-2 italianiSuddivisione delle attività in base agli interessi delle comunità di riferimento LNF e Roma1: Muon MDT Detector9 Roma1 è uno dei tre siti ATLAS dedicato alle calibrazioni Napoli: Muon RPC Detector Milano: Calorimetro e Pixel DetectorsI canali di fisica scelti per l’analisi sono determinati anche dalle forti competenzesviluppate nella comprensione degli stati finali leptoniciTutti i Tier-2 italiani di ATLAS hanno comunque continuato e continueranno acontribuire a tutte le attività di computing della collaborazione.Risorsedisponibilifine 2006IV Workshop ATLAS & CMS: Bologna 2006Tier-2CPU (kSI2k)Dischi (TB)Frascati3515Milano7523Napoli8528Roma I10033Totale 300 100G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-234

La produzione in Italia nel 2006BARI2%Atlas Wall Clock Time Italian Region (Jan-Oct ROMA17%TORINO2%IV Workshop ATLAS & CMS: Bologna 2006PISA RIESTESPACI-LECCENAPOLI-ATLAS6%SPACI-NAPOLIG. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-235

La produzione neiTier-2 italiani nel2006Uso della CPU in un Tier-2 intermini di CPU e Wall TimeIV Workshop ATLAS & CMS: Bologna 2006G. Carlino:Carlino: ATLAS Software, Computing & Challenges nei TierTier-236

La Federazione italiana dei Tier-2La Federazione include tutti i “flavour” di Tier-2 italianiCompiti della Federazione: Rappresentare univocamente l’insieme dei Tier-2 Facilitare l’interfaccia con LCG, ATLAS Grid, INFN Grid Facilitare l’accesso alle risorse comuni dei Tier-2 agli utenti (in media 30-40 per sitodi cui 30-60% remoti) tutorial dei tool di grid definizioni dei datasets da replicare nei sit

Gli Executors (moduli Python), uno per ogni Grid flavour, ricevono i job-definitions in formato XML, li convertono nel linguaggio della particolare Grid e li sottomettono individuando le risorse ottimali (CPU vs Dati) sulle infrastrutture di calcolo DonQuijote (DQ2), il Data Management System, si occupa della gestione e distribuzione dei dataset.